Looker Studioが重くなる理由と解決方法

・Looker Studioが重くなりやすいのはスプレッドシートやCSV等のソースデータ

・特に、スプレッドシートは、KPI集計を重視している企業様ほど重くなりやすい

・スプレッドシートの特性を理解したうえでスリム化

・スリム化できない場合、Google BigQueryにスプレッドシートを取り込み内部テーブルに変換

Googleサーチコンソールを見ていると、どのような検索キーワードで弊社サイトに訪問されているか、傾向がある程度わかります。

そのなかで、ある検索キーワードで訪問される方が常に一定数いらっしゃいます。

それは「LookerStudioが重い」というお困りごとです。

「LookerStudioが重い!軽くしたい!」

弊社のお客様からも頻繁にご相談いただくもので、世界共通のLookerStudioあるある話かもしれません。

特にスプレッドシートを活用して、KPI集計を重視されている企業様ほど、LookerStudioが重くなる傾向にあるようです。

弊社のお客様には、KPI集計を重視されている企業様が多いです。

業態にもよりますが、特に、社内横断で売上データを共有されていたり、頻繁に更新する必要がある企業様においては、直感的に操作できて、数字も管理しやすいスプレッドシートが大活躍します。

スプレッドシートでKPI集計は限界がある

ただ、スプレッドシートで運用には限界があります。

スプレッドシートをご利用の方ならイメージしやすいと思いますが、レコード数やカラム数、関数、シート数が増えるほど、スプレッドシートの操作は重くなる傾向にあります。

一般的に、シート数は複数枚になることが多く、弊社のお客様において、スプレッドシート1枚のみで運用されていたことは1社様もありません。

複数枚のシートを使い、シート間を関数で参照・接続・・・といった使い方になりますが、この使い方は便利な反面、スプレッドシートの操作を重くする一因になります。

また、同時に、複数の方が編集することで拍車がかかります。

スプレッドシートは表計算が得意ですが、グラフや表などでグラフィカルに描画したり、スムーズ・動的にKPIをチェックする点おいては、圧倒的にBIのLookerStudioが優位になります。

このように、スプレッドシートは便利ですが、ある程度のレベルまで来ますと、スプレッドシートでKPI集計は限界があります。

スプレッドシートをLookerStudioのデータソースとするデメリット

このような場合、スプレッドシートをLookerStudioのデータソースとして参照し、BI側でKPI集計することがほとんどです。

しかし、このようなスプレッドシートを参照してしまうと、LookerStudioの操作感にもネガティブに影響します。

スプレッドシートのレコード数やカラム数、関数、シート数が増えるほど、LookerStudioの操作感も重くなる傾向にあります。

LookerStudioの描画が重くなり、もたつきが目立つようになると、データロードに時間がかかり、KPIをスムーズに集計できなくなります。

これは、とてもストレスフルなことです。

スプレッドシートを軽くできないか検討する

まずは、スプレッドシートを軽くできないか検討します。

述べた通り、スプレッドシートのレコード数やカラム数、関数、シート数が増えるほど、重くなります。

不要なシートやカラム削除し、関数もなるべく減らすことにより、ある程度は軽くすることができます。

しかし、この方法は、あまり現実的ではありません。

それは、KPI集計を重視されている企業様ほど、スプレッドシートを日常的に効率化されており、不要なシートやカラム等がほとんど見つからないためです。

また、スプレッドシートをBigQueryに連携済みで、LookerStudioのデータソースをスプレッドシートからBigQueryに変更済みであることがほとんどです。

BigQueryにスプレッドシートを取り込み内部テーブルに変換を検討する

このような場合、大きな効果を得られるのが、BigQueryを使った内部テーブルへの変換です。

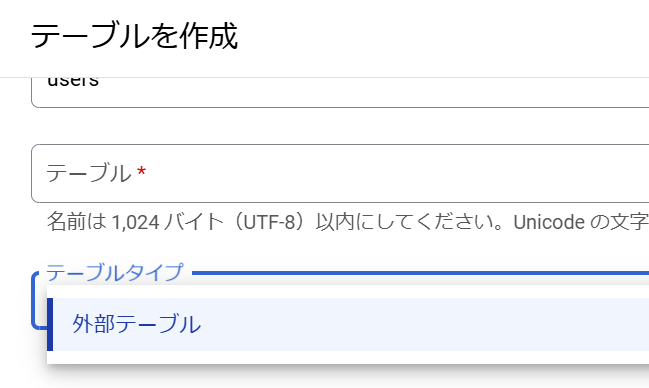

BigQueryのデータは外部テーブルと内部テーブルがあります。

外部テーブルは、BigQueryの外側にあるデータです。

スプレッドシートはGoogle Driveにあり、BigQueryの外側にあります。

そのため、BigQueryでテーブル化したスプレッドシートも外部テーブルになります。

BigQueryのテーブル作成画面。スプレッドシートは外部テーブルと表示される。

スプレッドシートをBigQueryのテーブルとして簡単に取り込めますが、このままでは解決しません。

外部テーブルはBigQueryの内部ストレージの外側にあり、内部テーブルよりアクセスビリティが劣ります。

そこで、この外部テーブルを内部ストレージに取り込むことで内部テーブルに変換し、アクセスビリティを高めて、LookerStudioの操作性を改善します。

手順は以下の通りです。とても簡単です。ぜひお試しください。

・BigQueryで、外部テーブルを内部テーブルに変換するプログラム(SQL)を作成

・スケジュール化して定期実行

プログラム例

CREATE OR REPLACE TABLE

`プロジェクト名.データセット名.外部テーブルの名前` AS

SELECT

*

FROM

`プロジェクト名.データセット名.スプレッドシートを取り込んだ内部テーブルの名前`

;

Google Cloud開発お承ります

datacompanyでは、お客様のご予算・環境に応じたクラウド開発を承ります。

お困りごとがございましたら是非ご相談ください。